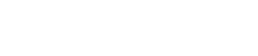

AI工具那么卷,Nano Banana怎么就出圈了? | You Know What

最近在社交媒体上最火的AI工具大概就是Google推出的Nano Banana,一个听起来小巧可爱却战斗力十足的图像生成模型,能让2D照片几秒内变精致手办,也能一键清除路人、拯救废片。

根据Google发布的数据,自8月中旬官宣以来,Nano Banana为Google Gemini带来超1000万的新用户,也让其超越ChatGPT,占据多地App Store榜首。今天就来看看,在AI赛道如此内卷的当下,Nano Banana怎么就水灵灵地出圈了?

01 不开发布会的匿名黑马

和Open AI在大型发布会高调官宣GPT不同,Nano Banana拿的是battle出道的剧本。

最初,在海外AI测评平台LMArena上,一个匿名模型在与Midjourney、DALL-E 3等众多顶尖模型的盲测PK中屡屡胜出,引起AI爱好者社区的疯狂猜测。随后,用户们通过分析图像元数据等技术手段推测其为Google尚未发布的Gemini Flash模型。

至于“Nano Banana”名字的来历,也有好几种说法。有论坛称,绰号是社区用户根据盲测时自动分配的代号“blueberry_1”延伸而来,也有人爆料,这是团队的工程师凌晨两点赶ddl时随意取的。更有传闻,Google内部训练此模型时经常会使用“make it nano”的指令来生成更加精细的图像,该模型还常常生成香蕉作为示例,因此得名。

以一敌百的武力,扑朔迷离的身份,让“Nano Banana”从一开始就自带话题效应。

直至今年8月底,Google高管和技术人员在社交媒体上分享香蕉相关的表情符号和艺术作品,并正式将其认领为Google最新的Gemini 2.5 Flash Image模型,这场技术社区内部的狂欢,逐渐进入了大众用户的视野。

02 低门槛+高精度的大众玩法

相信很多人注意到Nano Banana,应该是和我一样在网上刷到了各种创意玩法。抱着试一试的态度,没想到真的有惊喜。比如你家的猫咪在几秒内,就变成了电脑桌上的手办。虽然只是虚拟的3D效果,但整体还算真实。

这种低门槛的体验,得益于Nano Banana的自然语言编辑和 Gemini 系列模型丰富的知识库。当许多生图工具还存在“想调整一个细节,却把没问题的部分也改了”的bug,Nano Banana已经能支持像素级的精准控制,也更能听得懂“人话”。如果对图片不满意,只用输入简单的指令,在多次对话中调整指定的元素。

Nano Banana最明显的优势是“一致性”。

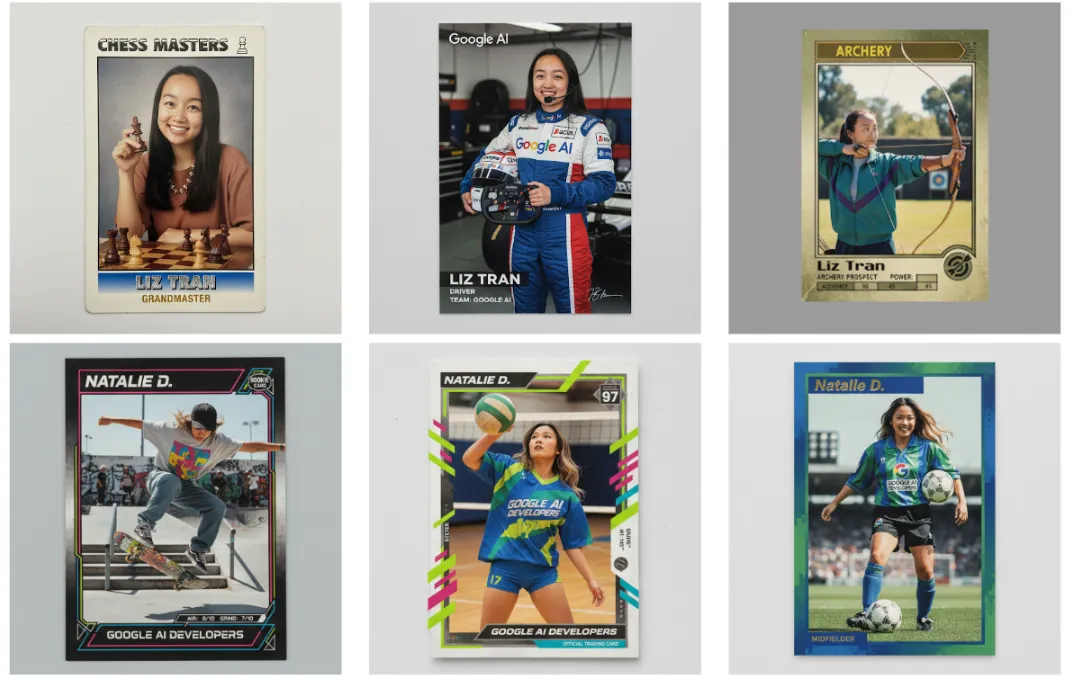

举例来说,以往当我们想让自己的人像照出现在不同的场景,甚至切换表情和动作时,常常面临“样貌改变”的问题。但Nano Banana能锁定面部结构,尽可能保留细节特征,让图片就像本人拍出来的一样。相比传统模型“并行”生成图片,Nano Banana采用了“Interleaved Generation(交错生成)”的技术,让每张图都能参考前面的图,更保障了用户在多轮编辑时的流畅度。

即使功能强大,但Nano Banana的运行速度并不慢,就像名字“flash”一样,几秒内就能输出新的结果。至少,不会把你的耐心耗在等待上。

因此官方正式认领不到一个月,各平台上已经涌现出丰富的玩法,覆盖娱乐到专业领域等多个场景。电商只需上传产品图和模特图,就能生成模特手持产品的图片;导演编剧输入关键元素,Nano Banana就会进行多图融合,快速输出脚本demo;室内设计通过“更换某一元素”的指令,就能预览不同家具搭配下的空间效果。

如果说Midjourney是服务于艺术爱好者的创意帮手,那么Nano Banana更像是每个人日常生活会用到的智能图片编辑器,以往需要动用PS、AI等多个专业软件才能完成的操作,现在只需要“动动嘴”便能完成。

这也意味着,它的热度不会止于发布,而是会有源源不断的新想象。